یکی از موارد اولیه مورد نیاز برای بهینه سازی سایت که متخصصان سئو در اصفهان و شهرهای دیگر هنگام کار بر روی سئوی فنی سایت در نظر می گیرند، ایجاد فایل Robots.txt است. اما فایل Robots.txt چیست؟

Robots.txt یک فایل متنی است که در وب سرور شما قرار دارد و توسط خزنده های وب مثل موتورهای جستجو برای درک نحوه جستجوی وب سایت شما استفاده می شود. به بیان دیگر این فایل به خزنده های موتور های جستجوگر دستور می دهد که چگونه محتویات و صفحات داخل سایت شما را بخزند. بنابراین داشتن یک فایل Robots.txt مناسب یکی از عناصر اساسی SEO برای وب سایت شما است.

به یاد داشته باشید فایل Robots.txt به شدت مستعد خطا است به طوری که یک اشتباه ساده یا یک پیکربندی غلط و ناخواسته می تواند باعث خرابی در سئوی سایت و از دست رفتن رتبه بندی سایت شما شود. بنابراین قبل از ایجاد و بهینه سازی فایل Robots.txt حتما نکات لازم را فرا بگیرید. در ادامه در وهله اول بررسی خواهیم کرد که فایل Robots.txt چیست و چه کاربردی دارد؟ سپس راحت ترین روش ایجاد آن را توضیح خواهیم داد.

همچنان با آژانس دیجیتال مارکتینگ بهیدو ارائه دهنده خدمات طراحی سایت در اصفهان ، طراحی فروشگاه اینترنتی و خدمات سئو در اصفهان همراه باشید. برای کسب اطلاعات بیشتر و دریافت مشاوره رایگان طراحی سایت با ما تماس بگیرید.

بیشتر بدانید: اهمیت سایت مپ برای سئو

فایل Robots.txt چیست؟

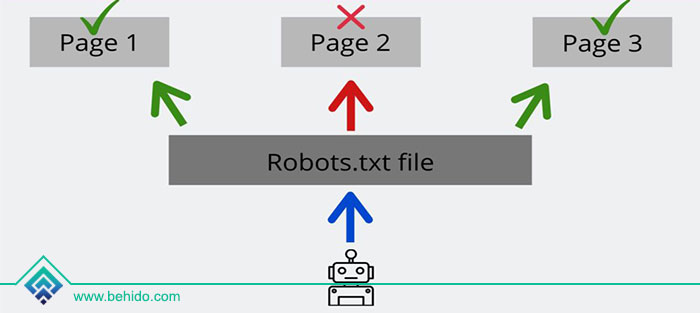

Robots.txt فایلی است که در دایرکتوری اصلی وب سایت شما قرار دارد. این فایل در واقع یک دستورالعمل برای خزنده موتورهای جستجو است که بر اساس آن تصمیم می گیرند کدام صفحات یا فایل های یک سایت را درخواست کنند.

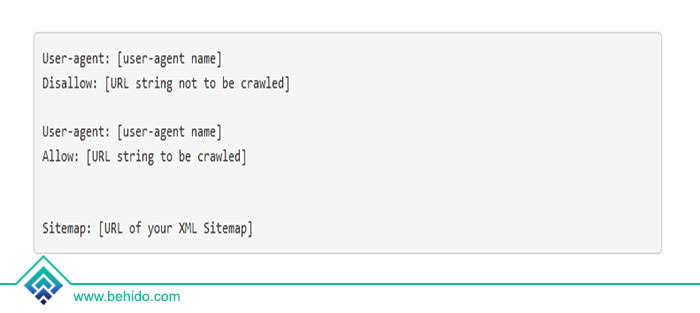

اولین چیزی که موتورهای جستجو هنگام بازدید از یک سایت به دنبال آن هستند، جستجو و بررسی محتوای فایل robots.txt است. سپس بسته به دستورالعمل های مشخص شده در این فایل، آنها لیستی از URL هایی را که می توانند در آن وب سایت خزنده و فهرست شوند، ایجاد می کنند. فرمت اصلی برای یک فایل Robots.txt به شکل زیر است:

مفهوم دستورهای فایل Robots.txt

User-agent: به یک ربات خاص اشاره دارد (به عنوان مثال موتور جستجو) که به آن دستورالعمل های خزیدن را می دهید. برای مراجعه به همه خزنده ها یا تعیین نام خزنده می توانید از یک * استفاده کنید. به مثال های زیر توجه کنید:

(شامل تمام خزنده ها است) User-agent: *

(دستورالعمل ها فقط برای ربات گوگل است.) User-agent: Googlebot

Disallow: فرمانی است که به ربات می گوید URL خاصی را خزنده نکند.

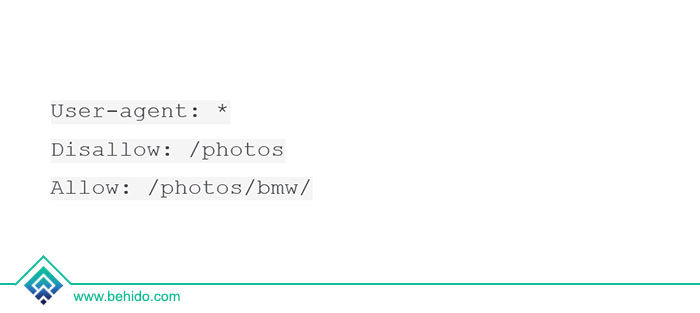

Allow: فرمانی است که به ربات می گوید تا یک URL خاص را حتی در یک فهرست غیر مجاز نیز خزش کند. به عنوان مثال، می توانید دسترسی به فهرست عکس خود را ممنوع کنید اما اجازه دسترسی به زیر پوشه BMW را بدهید که در زیر عکس قرار دارد:

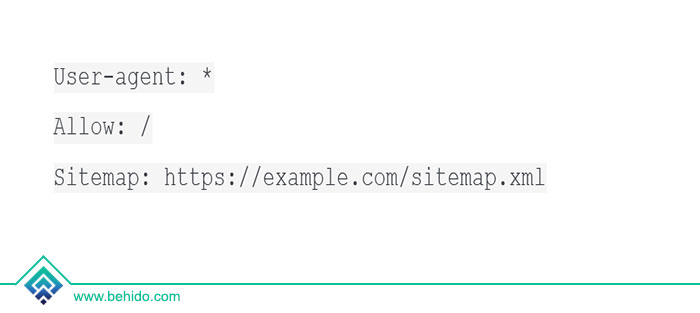

Sitemap: به تعیین محل نقشه سایت در ربات کمک می کند. (بهترین روش برای این کار قرار دادن دستورالعملهای نقشه سایت در انتهای یا ابتدای پرونده robots.txt است.) البته حتی اگر مکان نقشه سایت XML را در ربات ها مشخص نکنید، موتورهای جستجو همچنان قادر به یافتن آن هستند.

Crawl-delay: به تعیین تعداد ثانیه هایی که خزنده باید قبل از خزیدن صفحه منتظر بماند، کمک می کند. معمولا یاهو و بینگ این دستورالعمل را اجرا می کنند و تاخیر خزش توسط Googlebot در نظر گرفته نمی شود.

نکته: Robots.txt به حروف کوچک و بزرگ حساس است و در صورت اشتباه دستورالعمل شما اجرا نمی شود.

فایل Robots.txt را در کجای وب سایت قرار دهیم؟

از نظر فنی ، می توانید robots.txt را در هر یک از دایرکتوری های اصلی وب سایت خود قرار دهید. اما کارشناسان سئو در اصفهان توصیه می کنند که همیشه این فایل را در ریشه دامنه خود قرار دهید. به عنوان مثال ، اگر دامنه شما www.xyz.com است، پس robots.txt شما باید در www.xyz.com/robots.txt پیدا شود.

بیشتر بدانید: چک لیست اقدامات سئو در سال ۲۰۲۲

اهمیت فایل Robots.txt چیست؟

مهم نیست وب سایت شما کوچک باشد و یا دارای یک وب سایت بزرگ باشید، در هر صورت داشتن یک فایل robots.txt برای سئو سایت شما مهم است. زیرا به گفته کارشناسان سئو در اصفهان این فایل به شما امکان کنترل بیشتر حرکت موتورهای جستجو در وب سایتتان را می دهد. مهم ترین موارد اهمیت فایل Robots.txt برای سایت شما عبارتند از:

- از اضافه بار سرور جلوگیری می کند.

- از قرار گرفتن موتورهای جستجو در معرض اطلاعات حساس سایت جلوگیری می کند.

- کمک می کند تا بخش هایی از وب سایت شما خصوصی بماند.

- از خزیدن محتوای تکراری جلوگیری می کند.

- از نمایه سازی فایل های غیرضروری در وب سایت شما (به عنوان مثال تصاویر ، ویدئو ، PDF) جلوگیری می کند.

- از خزیدن برای صفحات نتایج جستجوی داخلی جلوگیری می کند.

فایل Robots.txt چگونه کار می کند؟

به طور کلی موتورهای جستجو دو کار اساسی انجام می دهند که عبارتند از:

- پیدا کردن محتوای جدید در وب

- فهرست کردن محتوای یافت شده برای کاربرانی که به دنبال آن اطلاعات هستند.

بنابراین، خزنده پس از ورود به یک وب سایت، به دنبال یک فایل robots.txt می گردد. هنگامی که فایل robots.txt را پیدا کرد، خزنده ابتدا آن را مرور می کند و جستجوی محتوا در وب سایت شما را بر اساس دستورالعمل های آن انجام می دهد. همچنین اگر در مورد بخشنامه هایی که فعالیت خرنده را ممنوع می کنند، اشاره خاصی در این فایل نشده باشد، خزنده شروع به خزیدن سایر اطلاعات در سایت می کند.

چگونه یک robots.txt ایجاد کنیم؟

ایجاد یک فایل robots.txt آسان است. همه آنچه شما نیاز دارید یک ویرایشگر متن (مانند notepad) و دسترسی به پرونده های وب سایت خود (از طریق FTP یا صفحه کنترل) است. اما قبل از شروع به کار در ایجاد فایل ربات ها، اولین کاری که باید انجام دهید این است که بررسی کنید آیا قبلاً این فایل را ساخته اید یا خیر. آسانترین راه برای انجام این کار، باز کردن یک پنجره مرورگر جدید و رفتن به https://www.yourdomain.com/robots.txt است

اگر چیزی مشابه دستورالعمل های فایل robots.txt که قبلا به آن اشاره شد را مشاهده کردید، به این معنی است که شما در حال حاضر یک فایل robots.txt دارید و می توانید به جای ایجاد یک پرونده جدید، فایل موجود را ویرایش کنید.

نحوه ویرایش robots.txt

از سرویس گیرنده FTP مورد علاقه خود استفاده کنید و به فهرست ریشه وب سایت خود متصل شوید. Robots.txt همیشه در پوشه اصلی قرار دارد. فایل را در رایانه خود بارگیری کنید و آن را با یک ویرایشگر متن باز کنید. تغییرات لازم را انجام دهید و پرونده را مجددا در سرور خود بارگذاری کنید.

نحوه ایجاد یک robots.txt جدید

اگر از قبل این فایل را ندارید با استفاده از ویرایشگر متن، یک فایل .txt جدید ایجاد کنید ، دستورالعمل های خود را اضافه کنید، آن را ذخیره کرده و در پوشه اصلی وب سایت خود بارگذاری کنید. حتما مطمئن شوید که نام پرونده شما robots.txt است و نه چیز دیگری. همچنین، به خاطر داشته باشید که نام پرونده به حروف کوچک و بزرگ حساس است و باید همه آنها کوچک باشد.

robots.txt باید همیشه در ریشه وب سایت شما باشد و در هیچ پوشه ای قرار نگیرد.

یک مثال معمولی از robots.txt

در یک سناریوی معمول ، پرونده robots.txt شما باید دارای محتوای زیر باشد:

این کد به همه ربات ها اجازه می دهد بدون هیچگونه انسداد و محدودیت به وب سایت شما دسترسی داشته باشند. همچنین مکان نقشه سایت را تعیین می کند تا مکان یابی آن برای موتورهای جستجو آسان تر باشد.

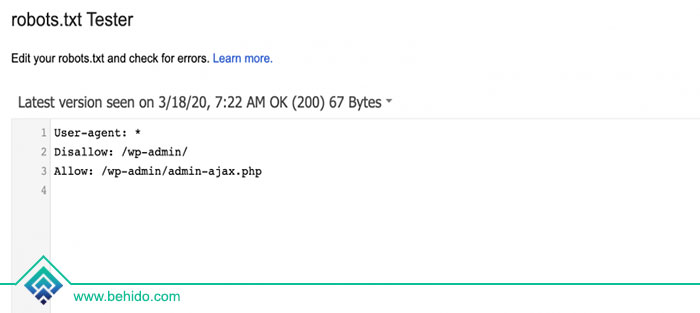

چگونه robots.txt خود را آزمایش و اعتبار سنجی کنیم؟

در حالی که می توانید با رفتن به URL robots.txt ، محتوای robots.txt خود را مشاهده کنید ، بهترین روش برای تست و اعتبار سنجی آن از طریق robots.txt Tester ابزار Google Search Console است.

به ابزار تستر Robots.txt بروید و روی دکمه Test کلیک کنید. اگر همه چیز خوب باشد ، دکمه Test سبز می شود و برچسب به مجاز تغییر می کند. اما اگر مشکلی وجود داشته باشد، خطی که باعث عدم اجازه می شود برجسته می شود.

در اینجا برخی از مهمترین دلایل استفاده از robots.txt آورده شده است:

- ۱- با کمک این فایل می توانید دسترسی به موتورهای جستجو را مدیریت کنید

محدود کردن دسترسی مرورگر به صفحات، فایلها و محتوای وبسایت انتخاب شده، رایجترین دلیل استفاده از robots.tkt است.

اگر سوالی دارید که چرا نباید برخی از صفحات یا فایل ها را ایندکس کنیم، پاسخ این است که در بسیاری از موارد ایندکس و بارگذاری صفحات یا فایل ها از وب سایت در موتور جستجو می تواند منجر به نتایج نامناسب شود.

مثلا گاهی مدیر سایت می خواهد مطلب خاصی را منتشر کند و مخاطب آن مقاله نیز افراد خاص و نخبه هستند. این مقاله ممکن است در برخی موارد قوانین خاصی از موتورهای جستجو را نقض کند یا حاوی محتوایی باشد که قابل نمایش عمومی نباشد.

در این صورت می توانید با کمک فایل Robots.txt دسترسی موتور جستجو به این صفحات یا فایل ها را محدود کنید.

بارزترین نمونه در این صنعت سایت های اشتراک گذاری فایل غیرقانونی از جمله سایت های تورنت هستند. بسیاری از این سایت ها به ربات های جستجوگر اجازه دسترسی به محتوای داخلی خود را نمی دهند و در عوض موتورهای جستجوی داخلی خود را به کاربران ارائه می دهند.

زیرا اگر ربات ها محتوای این سایت ها را شناسایی کنند، این سایت ها نه تنها رتبه و جایگاه خود را در موتورهای جستجو به دلیل ارائه محتوای غیرقانونی از دست می دهند، بلکه دچار مشکلات کپی رایت و موارد مشابه نیز خواهند شد.

بیشتر بدانید: حل رایج ترین مشکلات فنی سایت

- ۲. عدم استفاده از فایل robots.txt ممکن است منجر به کاهش عملکرد بهینه سایت شود.

وب سایت های فعال، به ویژه وب سایت های بزرگ و محبوب، روزانه هزاران بار توسط ربات های مختلف از موتورهای جستجو بازدید و خزیده می شوند.

هر ربات یا به اصطلاح خزنده اطلاعات را از سایت ها در یک فرآیند دو مرحله ای (اسکن و سپس نمایه سازی) جمع آوری می کند. این فرآیند شامل بررسی تمام قسمت های سایت شما می شود.

حال اگر روزانه صدها یا هزاران ربات شروع به خزیدن و جمع آوری داده ها از سایت شما کنند، عملکرد بهینه سایت شما و سرعت بارگذاری اطلاعات برای مرورگرها به شدت افزایش می یابد.

واضح است که این میزان ترافیک ربات می تواند عملکرد کلی یک وب سایت را در شرایط نامساعد به طور قابل توجهی تحت تاثیر قرار دهد. البته این مشکل برای سایت های کم بازدید کمتر است، اما برای سایت های پربازدید که باید ترافیک هزاران نفر را مدیریت کنند.

افزودن ترافیک زیاد از این ربات ها که هر روز استفاده می شوند نیز می تواند مشکل ساز باشد.

در چنین مواقعی بسیاری از وب مسترها به سادگی از فایل robots.txt استفاده می کنند تا دسترسی ربات های جستجوگر را به بخش های مختلف و خاصی که برای سئو و رتبه بندی موتورهای جستجو اهمیت زیادی ندارند محدود کنند.

در این صورت نه تنها سرور سایت با ترافیک کمتری کار می کند، بلکه مراحل بررسی و جمع آوری اطلاعات و سپس ایندکس کردن آنها توسط ربات ها نیز سریعتر انجام می شود.

- ۳. استفاده از فایل robots.txt می تواند در مدیریت لینک ها مفید باشد

یکی دیگر از مزایای استفاده از robots.txt امکان مدیریت لینک ها و آدرس های صفحه (URL) است. در بحث سئو مشکلی به نام ساعت URL وجود دارد. این بحث در واقع نوعی استراتژی سئو برای پنهان کردن آدرس صفحات از چشم کاربران یا موتورهای جستجو است.

با کمک robots.txt می توانید مدل لینک ها را مدیریت کرده و آدرس آنها را مخفی کنید.

رایج ترین استفاده در این زمینه استفاده از لینک های مرتبط با بحث «سیستم های فروش وابسته» یا «بازاریابی وابسته» است. در این صورت می توانید لینک های ایجاد شده در سیستم وابسته که به لینک های وابسته معروف هستند را مدیریت کنید و آدرس آنها را مخفی کنید تا کاربران به نوعی مجبور به کلیک بر روی آن ها شوند.

توجه داشته باشید که این تکنیک فقط باید توسط متخصص انجام شود. از آنجا که پنهان سازی URL یک تکنیک سئو کلاه سیاه است، اگر آن را به درستی پیاده سازی نکنید، متهم به نقض قوانین موتور جستجو و جریمه شدن توسط گوگل خواهید شد.

برای دریافت خدمات طراحی سایت در اصفهان ، طراحی فروشگاه اینترنتی و خدمات سئو در اصفهان با ما همراه باشید. جهت کسب اطلاعات بیشتر و دریافت مشاوره رایگان طراحی سایت با ما تماس بگیرید.